در این مقاله سعی داریم فایل robots.txt که یکی از مباحث مهم در مدیریت وب سایت و سئو می باشد را معرفی کنیم. برای آشنایی بهتر با فایل robots.txt بهتر است با روش کار موتورها جستجو و ربات های جستجو و همچنین نحوه ایندکس شدن صفحات وب سایت ها آشنا شوید.

موتورهای جستجو و ربات های جستجو چگونه کار می کنند؟

موتورهای جستجو همانند گوگل، یاهو و بینگ مایکروسافت از طریق ربات های جستجو که به spider ،robot و یا crawler معروف هستند صفحات مختلف وب و سایت های موجود را پیدا کرده و ایندکس می کنند.

ربات های وب که به نام های خزندگان یا عنکبوت ها نیز شناخته می شوند به برنامه هایی می گویند که به صورت خودکار سراسر وب را پیمایش کرده و جستجو می کنند.

ربات های جستجو به صورت خودکار در وب سایت ها و صفحات مختلف وب پیمایش کرده و اطلاعات مربوط به وب سایت ها را بدست می آورند و آن ها را به موتور جستجوی مربوطه ارسال می کنند.

شاید برایتان سوال پیش بیاید که این ربات ها چه زمان هایی به وب سایت شما سر می زنند؟ معمولا این ربات ها بر اساس زمان هایی که یک وب سایت بروز می شود به آن ها مراجعه می کنند. به عنوان مثال میزان مراجعه این ربات ها به وب سایت هایی که روزانه چندین بار آپدیت می شوند، بسیار بیشتر از وب سایت هایی است که در ماه یکبار آپدیت می شوند.

فایل robots.txt چیست؟

فایل متنی با فرمت txt است که وبمسترها بوسیلهی آن میتوانند چگونگی خزیده شدن و ایندکس شدن وب سایت شان توسط رباتهای موتور جستجوگر را تعیین کنند. مدیران وب سایت ها با استفاده از robots.txt ساختار سایتشان به ربات های جستجو معرفی می کنند. در واقع صاحبان سایت ها با استفاده از این فایل قادر خواهند بود تا سطح دسترسی ربات ها به سایت خود را مشخص نمایند و یا حتی در صورت وجود موارد حساس در سایت، می توانند از دسترسی ربات ها به آن صفحه جلوگیری نمایند.

به عنوان مثال فرض کنید شما می خواهید از ایندکس شدن برخی از صفحات وب سایت خود در موتورهای جستجو جلوگیری نمایید. صفحاتی که محتوای قابل قبولی ندارند و شما ترجیح میدهید آن صفحات، تا تکمیل نهایی در موتورهای جستجو ثبت نشوند. در واقع زمانی که می خواهید صفحات بی ارزش و کم محتوا را از دید موتورهای جستجو پنهان کنید، در چنین شرایطی دقیقاً فایل robots.txt برای کمک وارد میشود.

هنگامی که ربات های جستجو وارد سایت شما می شوند، در ابتدا و قبل از هرچیزی به سراغ آدرس فایل ربات سایت شما خواهند رفت و بر اساس آن صفحات مختلف وب سایت شما را جستجو خواهند کرد.

نکته:

همهی رباتها از این دستورات پیروی نمیکنند. برای مثال رباتهای Email Harvesters و Spambots Malware یا رباتهایی که امنیت وب سایت شما را بررسی میکنند، ممکن است اصلاً از این دستورات پیروی نکنند و حتی کار خود را از بخش هایی از سایت آغاز کنند که اجازه ی دسترسی به آن ها را ندارند.

آموزش ساخت فایل robots.txt

یک فایل ساده برای مدیریت ربات های اینترنتی از دو قانون اصلی استفاده می کند که عبارتند از:

User-agent: نشان دهنده نوع رباتی است که نباید به صفحه دسترسی داشته باشد.

Disallow: بیانگر آدرس صفحه ای است که می خواهید از دید ربات ها پنهان بماند.

با ترکیب این دو دستور می توانید قوانین مختلفی را برای دسترسی به صفحات داخلی سایت تعریف کنید. بعنوان مثال برای یک user-agent مشخص، می توان چندین آدرس را معرفی نمود و یا برعکس.

لیست ربات های اینترنتی معتبر در دیتابیس Web Robots Database

شما می توانید با قرار دادن نام هر یک از این ربات ها بعنوان User-agent قوانین مشخصی برای آنها تعریف کنید و یا با استفاده از کاراکتر * به جای نام در فایل robots.txt یک قانون را برای همه ربات ها اعمال کنید. مانند:

*:User-agent

/Disallow: /folder1

موتور جستجوی گوگل چندیدن نوع ربات مخصوص به خود دارد که معروف ترین آنها با نام Googlebot شناخته می شود و وظیفه بررسی و ایندکس صفحات وب را برعهده دارد. ربات Googlebot-image نیز مسئول بررسی تصاویر سایت ها و ایندکس کردن آنها می باشد.

User-Agent: Googlebot

Disallow:/folder2/

شما می توانید به روش های مختلفی قوانین خود را اعمال کنید، می توان یک صفحه مشخص و یا یک دسته از صفحات را برای یک قانون تعریف نمود. مثال های زیر روش های مختلف استفاده از این قوانین هستند:

برای عدم دسترسی ربات ها به تمام محتویات سایت از کاراکتر / استفاده می کنیم:

Disallow:/

برای عدم دسترسی به یک فولدر یا دسته از سایت نام آن را وارد کنید:

Disallow: /blog/

برای اعمال محدودیت روی یک صفحه خاص آدرس دقیق آن را بدون نام سایت وارد کنید:

Disallow: /blog/keyword-planner/

برای محدود کردن یک تصویر بر روی سایت آدرس آن را به همراه User-agent مربوط به آن وارد کنید:

User-agent: Googlebot-Image

Disallow: /images/dogs.jpg

و برای مخفی کردن تمام تصاویر موجود بر روی سایت از دید موتورهای جستجو از دستور زیر استفاده کنید;

User-agent: Googlebot-Image

Disallow:/

همچنین شما می توانید یک نوع فایل مشخص را از دید موتورهای جستجو مخفی نگه دارید، بعنوان مثال برای تصاویری با فرمت gif

User-agent: Googlebot

Disallow: /*.gif$

فایل robots.txt نسبت به بزرگ و کوچک بودن حروف انگلیسی حساس بوده و آدرس صفحات باید به دقت وارد شوند.

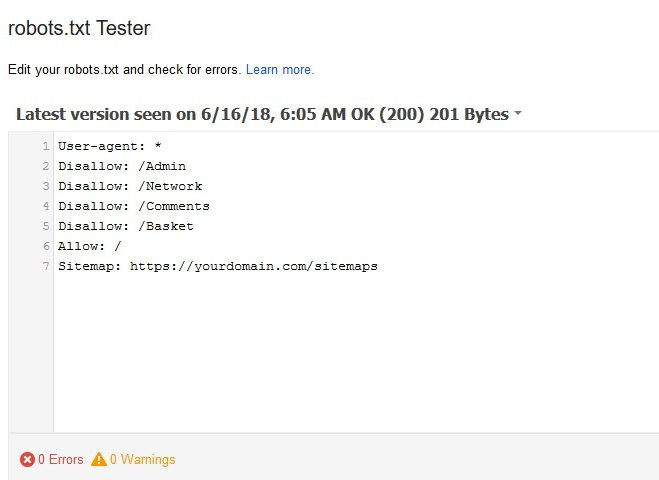

تصویر زیر نمونه ای از یک فایل robots.txt را نمایش می دهد:

بعد از ایجاد فایل robots.txt چه باید کرد؟

1. پس از ساخت فایل مورد نظر خود و ذخیره آن در فرمت txt آن را بر روی سرور و در ریشه اصلی کپی کنید.

قوانین اعمال شده برای ربات هایی هستند که از این پس به سایت شما وارد می شوند حذف صفحاتی که در گذشته ایندکس شده اند از دیتابیس گوگل نیازمند گذشت زمان خواهد بود.

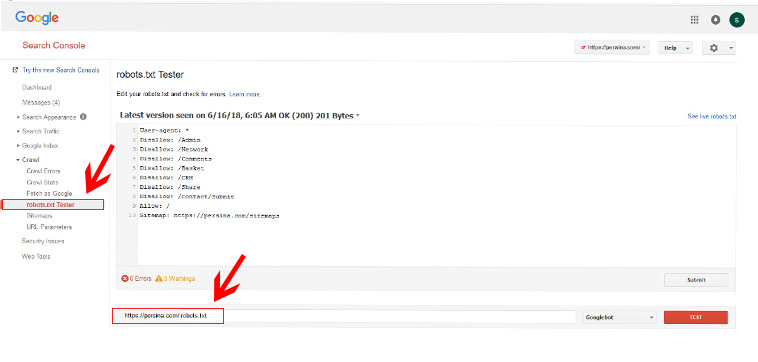

2. فایل robots.txt در وب مستر تولز ثبت کنید.

وارد وب مستر تولز شوید. (برای این کار حتما باید از قبل وب سایت خود را در وب مستر تولز ثبت کنید)

برای آشنایی با نحوه ثبت وب سایت در وب مستر تولز اینجا کلیک کنید.

از منوی سمت چپ گزینه ها و مسیر Crawl> robots.txt Tester دنبال کنید و طبق تصویر در فیلد مشخص شده عبارت robots.txt را وارد کنید و روی دکمه TEST کلیک کنید تا با پیغام سبز رنگ Allowed مواجه شوید.

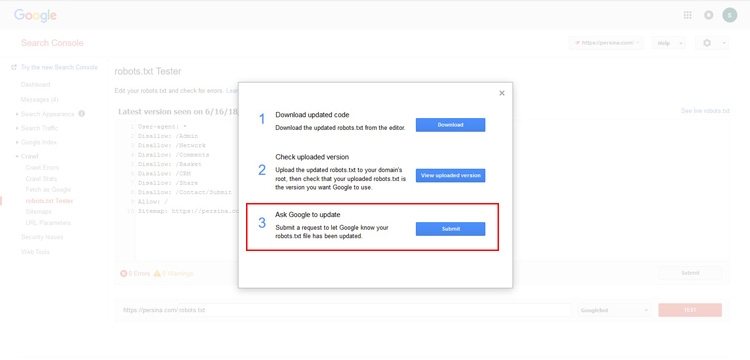

اگر درست بود محتویات فایل robots.txt را وارد ویرایشگری که مشاهده می کنید وارد کرده و روی دکمه Submit کلیک کنید تا پنجره زیر برای شما نمایش داده شود:

در این قسمت ما چون از قبل فایل را در هاست آپلود کرده ایم با کلیک روی دکمه Submit گزینه سوم را انتخاب کردیم.

نکته:

نقشه سایت یا Sitemap خود را در این فایل مشابه نمونه زیر وارد کنید تا وقتی رباتهای جستجوگر فایل robots.txt را بررسی میکنند نقشه سایت را مشاهده کرده و قبل از هر صفحه از سایت این صفحه را مورد بررسی قرار دهند تا سرعت ایندکس صفحات شما بیشتر شود. برای این کار کافی است تا دستور زیر را در خط انتهایی این فایل وارد کنید.

Sitemap:https://persina.com/sitemaps

در صورتی که این مطلب برای شما مفید بود، می توانید آن را از طریق شبکه های اجتماعی زیر به اشتراک بگذارید. همچنین شما می توانید موضوعات مورد علاقه خود در زمینه طراحی سایت، طراحی فروشگاه اینترنتی، سئو و دیجیتال مارکتینگ را برای ما ارسال نمایید تا مقالات موردنظرتان را انتشار دهیم.

آیا سوالی در رابطه با فایل robots.txt برایتان باقی مانده است؟

اگر هنوز سوالی در رابطه با این موضوع دارید، سوالاتتان را برای ما ارسال کنید تا در اولین فرصت به آن ها پاسخ دهیم.